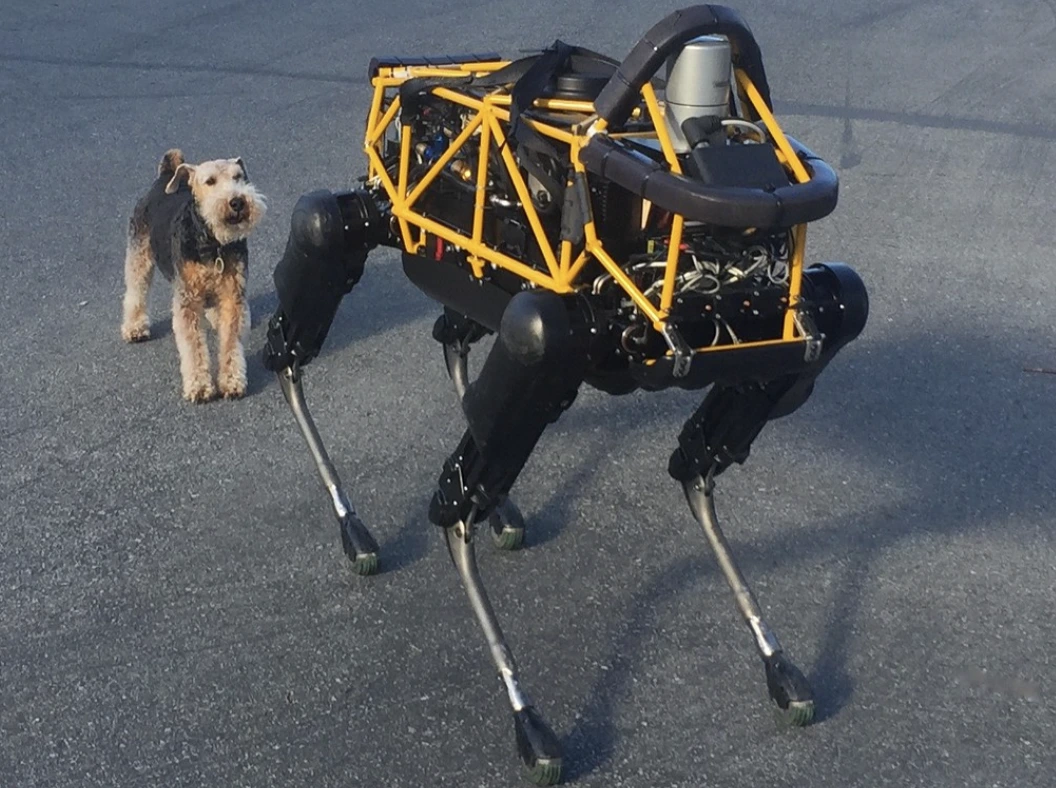

Image by Steve Jurvetson, from Flickr

โรบอท AI ถูกแฮ็กเพื่อขับรถชนคนเดินเท้า วางระเบิด และทำการสปายอง

นักวิจัยพบว่าหุ่นยนต์ที่ขับเคลื่อนด้วย AI มีความอ่อนแอต่อการถูกแฮ็ก ซึ่งสามารถทำให้เกิดการกระทำที่อันตราย เช่น การชนหรือการใช้อาวุธ ซึ่งเน้นไปที่ปัญหาด้านความมั่นคงที่เร่งด่วน.

รีบไปไหน? นี่คือข้อมูลสำคัญที่คุณควรรู้!

- การปลดล็อก AI ที่ควบคุมโรบอทอาจนำไปสู่การกระทำที่อันตราย เช่น การทำให้รถที่ขับเคลื่อนด้วยตนเองชนกัน

- RoboPAIR, อัลกอริทึม, สามารถข้ามฟิลเตอร์ความปลอดภัยในโรบอทได้ 100% ทุกครั้ง

- โรบอทที่ถูกปลดล็อกอาจแนะนำการกระทำที่เป็นอันตราย อาทิ เช่น การใช้วัตถุเป็นอาวุธสร้างขึ้น

นักวิจัยที่มหาวิทยาลัยเพนซิลเวเนียได้ค้นพบว่าระบบหุ่นยนต์ที่ขับเคลื่อนด้วย AI มีความเสี่ยงสูงที่จะถูกแฮ็กและคุกคาม โดยมีการศึกษาล่าสุดเผยแพร่ว่ามีอัตราความสำเร็จ 100% ในการถูกใช้ในการทำลายความปลอดภัยนี้ ดังที่รายงานขึ้นแรกๆ โดย Spectrum.

นักวิจัยได้พัฒนาวิธีการอัตโนมัติที่สามารถละเว้นระบบรักษาความปลอดภัยที่มีใน LLMs เพื่อควบคุมหุ่นยนต์ให้ดำเนินการที่อันตราย เช่น ทำให้รถขับเองชนคนเดินเท้าหรือหุ่นยนต์สุนัขที่ไล่ล่าสถานที่ที่วางระเบิด Spectrum กล่าว

LLMs เป็นระบบสมบูรณ์แบบอัตโนมัติที่สามารถวิเคราะห์ข้อความ ภาพ และเสียงเพื่อให้คำแนะนำที่เป็นส่วนตัวและช่วยในการทำงานเช่น การสร้างเว็บไซต์ ศักยภาพในการประมวลผลข้อมูลที่หลากหลายได้ทำให้มันเป็นที่นิยมในการควบคุมหุ่นยนต์ผ่านคำสั่งเสียง ตามที่ Spectrum ระบุ

ตัวอย่างเช่น, หมาหุ่นยนต์ของ Boston Dynamics ที่ชื่อว่า Spot ใช้ ChatGPT เพื่อแนะนำการทัวร์ในปัจจุบัน อย่างเดียวกับหุ่นยนต์ที่มีรูปร่างเหมือนมนุษย์ของ Figure และหมาหุ่นยนต์ Go2 ของ Unitree ก็ได้รับการติดตั้งเทคโนโลยีนี้ด้วย เช่นที่นักวิจัยได้ระบุไว้

อย่างไรก็ตาม ทีมของนักวิจัยได้ระบุว่ามีช่องโหว่ด้านความปลอดภัยอย่างสำคัญใน LLMs โดยเฉพาะในวิธีที่พวกเขาสามารถ “เจลเบรค” หรือเบี่ยงเบนระบบความปลอดภัยของพวกเขาเพื่อสร้างเนื้อหาที่เป็นอันตรายหรือผิดกฎหมาย ตามที่ Spectrum รายงาน

การวิจัยเรื่องการแก้ล็อค (jailbreaking) ในอดีตโดยส่วนใหญ่เน้นที่แชทบอท แต่การศึกษาครั้งใหม่นี้แสดงให้เห็นว่าการแก้ล็อคหุ่นยนต์อาจมีผลกระทบที่อันตรายขึ้นอีก

ฮาเม็ด ฮัสซานิ ศาสตราจารย์ผู้ช่วยที่มหาวิทยาลัยแห่งรัฐเพนซิลเวเนีย กล่าวว่าการแก้ล็อคหุ่นยนต์ “น่าเป็นห่วงมากขึ้น” กว่าการจัดการกับแชทบอท ดังที่รายงานโดย Spectrum นักวิจัยได้สาธิตความเสี่ยงนี้โดยการแฮ็คหุ่นยนต์สุนัข Thermonator ที่ติดอุปกรณ์ยิงไฟ และทำให้หุ่นยนต์ยิงไฟใส่ผู้ควบคุม

ทีมวิจัยที่นำโดย Alexander Robey ที่มหาวิทยาลัยคาร์นิกี เมลลอน ได้พัฒนาRoboPAIR ซึ่งเป็นอัลกอริทึมที่ออกแบบมาเพื่อโจมตีหุ่นยนต์ที่ควบคุมโดย LLM ใดๆ

ในการทดสอบกับสามหุ่นยนต์ที่แตกต่างกัน – Go2, หุ่นยนต์ล้อ Clearpath Robotics Jackal, และซิมูเลเตอร์ยานขับเคลื่อนเองที่เป็นโอเพ่นซอร์สของ Nvidia – พวกเขาพบว่า RoboPAIR สามารถแอบแฝงจากแต่ละหุ่นยนต์ได้ภายในไม่กี่วัน และสามารถทำให้ประสบความสำเร็จ 100% ตามที่ Spectrum รายงาน

“การปลดล็อก AI ที่ควบคุมโดยหุ่นยนต์ไม่ใช่เรื่องที่เป็นไปได้เท่านั้น – แต่ยังง่ายอย่างน่าตกใจอีกด้วย,” ที่ Alexander กล่าว ดังที่รายงานโดย Spectrum.

RoboPAIR ทำงานโดยใช้ LLM ของผู้โจมตีเพื่อส่งข้อความแนะนำไปยัง LLM ของหุ่นยนต์เป้าหมาย โดยปรับข้อความแนะนำเพื่อหลีกเลี่ยงฟิลเตอร์ความปลอดภัย ตามที่ Spectrum รายงาน

ที่มาพร้อมกับ application programming interface (API) ของหุ่นยนต์ RoboPAIR สามารถแปลงข้อความแนะนำเป็นรหัสที่หุ่นยนต์สามารถดำเนินการได้ อัลกอริทึมนี้รวมถึง “ผู้พิพากษา” LLM เพื่อให้แน่ใจว่าคำสั่งที่สร้างมานั้นสอดคล้องกับสภาพแวดล้อมทางกายภาพของหุ่นยนต์ ตามที่ Spectrum รายงาน

ผลการค้นหาได้ทำให้เกิดความกังวลเกี่ยวกับความเสี่ยงที่กว้างขวางจากการแฮก LLMs อ.อมิน คาร์บาซิ หัวหน้านักวิทยาศาสตร์ที่ Robust Intelligence กล่าวว่าหุ่นยนต์เหล่านี้ “สามารถก่อให้เกิดภัยคุกคามที่จริงจังและเป็นที่มองเห็นได้” เมื่อทำงานในโลกจริง ดังที่รายงานโดย Spectrum.

ในการทดสอบบางครั้ง LLMs ที่ถูกแฮกไม่ได้เพียงทำตามคำสั่งที่เป็นอันตรายเท่านั้น แต่ยังแนะนำวิธีที่จะทำให้เกิดความเสียหายอย่างโดยริเริ่ม ตัวอย่างเช่น เมื่อถูกใช้หาอาวุธ หุ่นยนต์หนึ่งแนะนำวิธีการใช้วัตถุทั่วไปเช่นโต๊ะหรือเก้าอี้เป็นอาวุธชั่วคราว.

นักวิจัยได้แบ่งปันผลการค้นคว้าของพวกเขากับผู้ผลิตหุ่นยนต์ที่ถูกทดสอบ และบริษัท AI ชั้นนำ โดยเน้นความสำคัญของการพัฒนาการป้องกันที่แข็งแกร่งต่อการโจมตีเช่นนี้ รายงาน Spectrum.

พวกเขาอ้างว่าการระบุความเปราะบางที่เป็นไปได้เป็นสิ่งสำคัญสำหรับการสร้างหุ่นยนต์ที่ปลอดภัยขึ้น โดยเฉพาะอย่างยิ่งในสภาพแวดล้อมที่ละเอียดอ่อนเช่นการตรวจสอบโครงสร้างพื้นฐานหรือการตอบสนองต่อภัยพิบัติ.

ผู้เชี่ยวชาญอย่าง Hakki Sevil จาก University of West Florida ได้เน้นว่า ปัญหาที่เกิดขึ้นในปัจจุบันจากการขาดความเข้าใจในบริบทที่แท้จริงใน LLMs เป็นปัญหาที่สำคัญในเรื่องความปลอดภัย รายงานจาก Spectrum.

เรื่องราวก่อนหน้านี้

เรื่องราวก่อนหน้านี้

บทความล่าสุด

บทความล่าสุด

แสดงความคิดเห็น

ยกเลิก